Cara Optimasi Robots.txt di Blogger

Cara Optimasi Robots.txt untuk memaksimalkan postingan dan mendapatkan lebih banyak lalu lintas organik.

Salah satu faktor utama dalam mengoptimalkan teknik SEO dengan membuat Robots.txt. Ketika mengunjungi website, tugas pertama yang dilakukan search engine adalah memeriksa file tersebut.

Sementara itu, kesalahan saat mengkonfigurasinya akan berdampak negatif pada peringkat halaman, bahkan blog secara keseluruhan.

Jadi, teruslah membaca artikel ini sampai selesai untuk memperoleh semua informasi yang mungkin Anda perlukan.

Apa itu Robots.txt?

Sebuah file teks yang berada di direktori root dari situs/blog, berfungsi sebagai alat pemberi intstruksi perayapan kepada mesin telusur.Apakah suatu halaman harus diindeks atau tidak, jadi itu tergantung daripada pengaturan di dalamnya.

Apakah Robots.txt itu Penting?

File yang dikenal sebagai protokol atau teks ini dapat memberitahukan kepada Robot web bahwa halaman mana saja yang ingin dirayapi atau tidak.katakanlah search engine mau mengunjungi sebuah blog, sebelum menjelajahi halaman target, ia akan memeriksa file ini terlebih dahulu.

Intinya, kesalahan penerapannya bisa berpengaruh negatif terhadap laman Anda, diantaranya adalah:

- Tidak mendapatkan optimasi dalam hal perayapan.

- Sangat rentan terhadap kesalahan SEO.

- Terbuka untuk melihat data sensitif.

- Lebih mudah bagi pengguna yang berniat jahat untuk meretas blog Anda.

- Mengeluarkan sinyal membingungkan ke search engine.

Baca Juga: 10 Tips Sebelum Mempublikasikan Artikel Baru

Cara Mengoptimalkan Robots.txt di Blogger

Adapun, langkah ini tergantung pada konten Anda sendiri bahwa pada dasarnya kamu tidak dianjurkan untuk memblokir laman web.Pasalnya, secara otomatis mesin perayapan dapat mengabaikan atau non-indeks dan tidak muncul di penelusuran.

Nah, berikut bagaimana tips melakukan konfigurasi Robots.txt pada blog Anda dengan benar.

1. Tambahkan script ini pada template HTML tepat di atas kode </head>. Kemudian save.

<meta content='noindex' name='robots'/>

<b:if cond='data:blog.searchLabel'>

<meta content='noindex,nofollow' name='robots'/>

<b:if cond='data:blog.isMobile'>

<meta content='noindex,nofollow' name='robots'/>

2. Masukkan kode berikut ke Setelan Blogger > Crawler dan pengindeksan > Taruh di Robots.txt custom.

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /search

Allow: /

Sitemap: https://nama-blog-anda/sitemap.xml

Atau, kalau Sobat mau mengatur halaman yang tidak ingin diindex, misalnya: about us, disclaimer, kontak, dll bisa mengikuti contoh seperti ini.

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /p/about

Disallow: /p/Disclaimer

Allow: /

Sitemap: https://nama-blog-anda/sitemap.xml

Keterangan

Sintaks diatas dianggap sebagai "bahasa dalam Robots.txt," biasanya ada beberapa istilah umum, antara lain:- User Agen: Penjelajah web khusus yang berfungsi memberikan instruksi di mesin telusur.

- Disallow: Perintah terhadap agen-pengguna agar tidak merayapi URL tertentu, hanya satu baris per setiap URL.

- Allow: Perintah dari Googlebot untuk mengakses halaman atau subfolder, meskipun laman induknya mungkin tidak diizinkan (Khusus bagi Googlebot).

- Sitemap: Pemanggil lokasi kepada seluruh sitemap XML yang terkait dengan URL. Hanya didukung oleh Google, Ask, Bing, dan Yahoo.

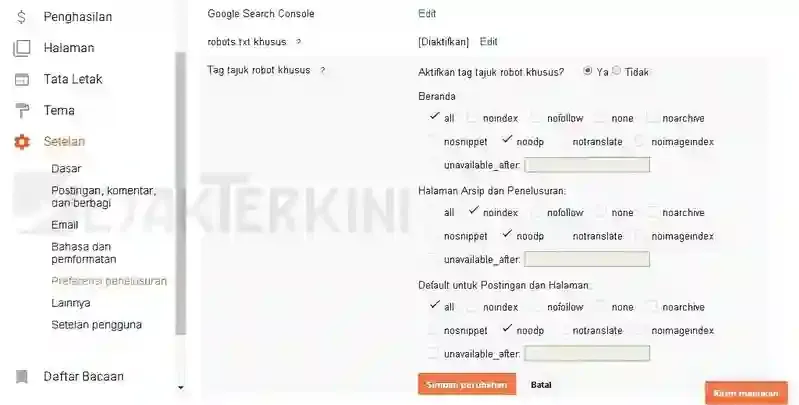

3. Selanjutnya, pada menu "Tag Tajuk Robot Khusus" silahkan atur seperti gambar di bawah ini.

Cara Menguji dan Memvalidasi Robots.txt

Langkah terbaik untuk memvalidasi adalah melalui opsi pengujian langsung dari Google Search Console.1. Masuk ke Robots Testing Tool > Lalu klik pada "Penguji" pada opsi Perayapan.

2. Setelah itu, tab pada bagian tombol Uji, jika semuanya ok, tombol Test akan berubah berwarna hijau dan label menjadi diperbolehkan.

Namun jika ada masalah, pesan biasanya menampilkan error atau warning disudut paling bawah.

Penutup

Kesalahan dalam penerapan Robots.txt dapat merusak peringkat Anda di SERPs. File atau folder apa pun yang tercantum dalam dokumen tersebut tidak akan dirayapi dan diindeks oleh spider mesin perayapan.Jadi, cara mengoptimasi Robots.txt adalah tugas yang perlu dilakukan ketika kamu baru pertama kali membuat blog, bahkan juga sebagai bagian dari teknik SEO.

Posting Komentar untuk "Cara Optimasi Robots.txt di Blogger"